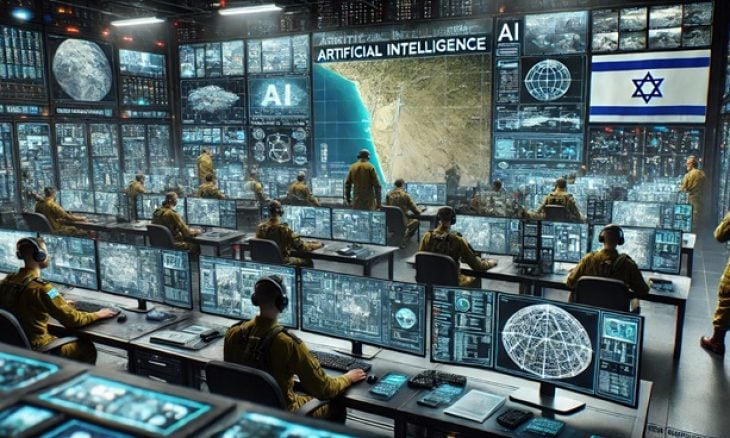

استخدام الذكاء الاصطناعي في العمليات العسكرية الإسرائيلية: تداعيات أخلاقية وإنسانية

عادل أبو شحادة

في تحقيق أجرته وكالة "أسوشيتد برس"، تم الكشف عن دور شركات تكنولوجيا أميركية، مثل مايكروسوفت وأوبن أيه آي، في دعم إسرائيل عبر توفير تقنيات الذكاء الاصطناعي التي تُستخدم لتحديد واستهداف المشتبه بهم في غزة ولبنان. هذا الاستخدام المكثف للذكاء الاصطناعي في العمليات العسكرية يثير تساؤلات أخلاقية وإنسانية حول مدى دقة هذه الأنظمة، وتأثيرها على المدنيين.

التقنيات المستخدمة وأهدافها

وفقًا للتقرير، يتم دمج أنظمة الذكاء الاصطناعي مع بيانات استخباراتية بشرية لتحسين دقة الاستهداف العسكري، هذه التقنيات تعتمد على تحليل البيانات الضخمة واستخدام نماذج تعلم الآلة لتحديد "التهديدات المحتملة" بسرعة كبيرة، مما يساعد في اتخاذ قرارات عسكرية بشكل شبه فوري.

لكن على الرغم من هذا التقدم التكنولوجي، فإن الاعتماد المفرط على الذكاء الاصطناعي في تحديد الأهداف العسكرية يطرح إشكالات عدة، من بينها احتمال حدوث أخطاء قاتلة بسبب سوء تصنيف الأفراد أو سوء تفسير البيانات، كما أن هذه الأنظمة قد تكون عرضة للاستغلال السياسي والعسكري، مما يزيد من خطر استخدامها بطريقة غير مسؤولة.

الأخطاء القاتلة والتداعيات الإنسانية

أفادت التحقيقات بأن هذه الأنظمة الذكية ارتكبت أخطاء فادحة، مثل تصنيف طلاب في المرحلة الثانوية كمقاتلين محتملين، ما أدى إلى قصف أهداف مدنية، كما أشار التقرير إلى أن الضغوط التي يتعرض لها الضباط الشباب للإسراع في تنفيذ الهجمات تزيد من احتمال وقوع الأخطاء، حيث يتم أحيانًا استهداف أفراد بناءً على معطيات غير مؤكدة.

إن هذه الأخطاء تسببت في استشهاد مدنيين أبرياء، مما أثار انتقادات واسعة من قبل منظمات حقوق الإنسان والمجتمع الدولي. وقد أكدت العديد من التقارير أن الذكاء الاصطناعي، على الرغم من كونه أداة قوية، لا يزال يعاني من مشكلات التحيز في تحليل البيانات، ما يجعله غير موثوق بشكل كامل في بيئات معقدة كالحروب.

علاوة على ذلك، فإن الاستخدام المتزايد لهذه التقنيات يطرح تساؤلات حول مستقبل الحروب الحديثة، إذا أصبحت أنظمة الذكاء الاصطناعي مسؤولة عن اتخاذ قرارات حاسمة في ساحة المعركة، فقد يؤدي ذلك إلى زيادة حدة النزاعات وتقليل فرص الحلول السلمية، حيث ستصبح الحروب أكثر اعتمادًا على التكنولوجيا وأقل تحكمًا من قبل البشر.

المسؤولية الأخلاقية والقانونية

يثير استخدام الذكاء الاصطناعي في العمليات العسكرية تساؤلات قانونية وأخلاقية، خاصةً عندما تؤدي هذه التقنيات إلى مقتل مدنيين، فبموجب القانون الدولي، يجب على الأطراف المتحاربة اتخاذ جميع الاحتياطات الممكنة لحماية المدنيين، لكن إذا كان الذكاء الاصطناعي يحدد الأهداف بناءً على بيانات غير دقيقة، فمن يتحمل المسؤولية عن الأخطاء الناجمة عن ذلك؟

يُطالب العديد من الناشطين والمنظمات الحقوقية بوضع ضوابط صارمة على استخدام الذكاء الاصطناعي في العمليات العسكرية، بحيث يكون هناك إشراف بشري أكبر لضمان الحد من الأخطاء وتقليل الأضرار الجانبية التي تطال الأبرياء، كما أن بعض الباحثين يقترحون ضرورة وضع معايير أخلاقية واضحة تضمن عدم استخدام هذه التقنيات بشكل ينتهك القانون الإنساني الدولي.

مستقبل الذكاء الاصطناعي في الحروب

مع استمرار التطورات في الذكاء الاصطناعي، تبرز الحاجة إلى تطوير تشريعات دولية تحكم استخدامه في النزاعات المسلحة. يجب على الحكومات والشركات التكنولوجية العمل سويًا لضمان عدم إساءة استخدام هذه التقنيات بطرق قد تؤدي إلى تصعيد الصراعات أو ارتكاب انتهاكات جسيمة لحقوق الإنسان.

كما أن الشفافية في تطوير واستخدام هذه التقنيات يجب أن تكون أولوية، حيث ينبغي على الدول التي تعتمد على الذكاء الاصطناعي في عملياتها العسكرية أن توفر معلومات واضحة حول كيفية عمل هذه الأنظمة وضمان مراجعتها الدورية من قبل جهات مستقلة.

في المستقبل، يجب أن يكون هناك تعاون دولي لضمان استخدام التكنولوجيا العسكرية بطريقة مسؤولة، مع التركيز على حماية المدنيين وتقليل الأضرار الإنسانية. وإلى أن يتم وضع إطار قانوني صارم ينظم استخدام الذكاء الاصطناعي في الحروب، سيظل هذا الموضوع محور جدل واسع في الأوساط القانونية والسياسية والعسكرية.